2024年1月21日、オリオンスターロボティクス(OrionStar)は、グランドローンチイベントを開催し、オープンソースのマルチリンガル大規模言語モデル「Orion-14B」をリリースしました。

Orion-14B基盤モデルは、140億のパラメータを持つマルチランゲージの大規模モデルで、さまざまな言語に対応するために2.5兆トークンの多様なデータセットでトレーニングされました。このデータセットには、中文、英語、日本語、韓国語などが含まれています。モデルは、多言語環境でのさまざまなタスクにおいて卓越した性能を発揮しています。

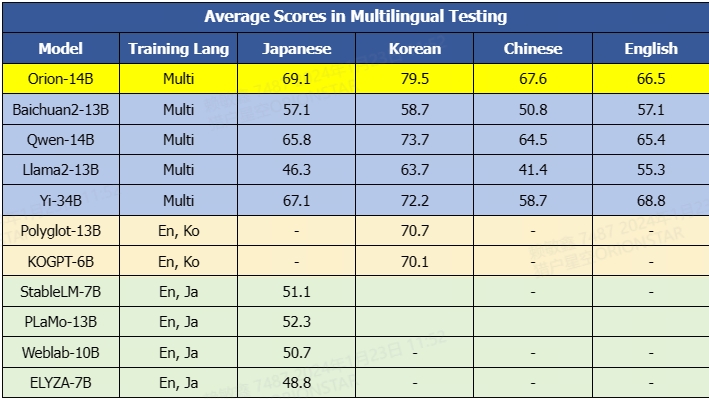

Orion-14Bは、主要なパフォーマンスベンチマークで優れた結果を示し、同じパラメータ数を持つ他のベースモデルを明らかに凌駕しています。(具体的な技術の詳細については、https://github.com/OrionStarAI/Orion/blob/master/doc/Orion14B_v3.pdfを参照してください。)

Orion-14Bシリーズのモデルは、以下の特徴を備えています:

基座20Bパラメータモデルは、総合的な評価で優れた結果を示しています。

多言語対応力が強く、特に日本語と韓国語の対応能力が優れています。

ファインチューニングモデルは適応性が高く、人間の注釈つきブラインドテストでは高性能なパフォーマンスを発揮しています。

長文対応バージョンは非常に長いテキストをサポートし、20万トークンの長さで優れた効果を発揮し、最大で320,000トークンまでサポート可能です。

量子化バージョンではモデルサイズが70%縮小し、推論速度が30%向上し、性能の損失が1%以下です。

また、このモデルシリーズは7つ特化したモデル*を含めています。それぞれのシナリオアプリケーションにより、特徴を備えています。ユーザーはご自身のニーズに合わせ、モデルを使用するができます。それに、企業のために、Orion-14Bに基づく包括的なアプリケーションソリューション『ChatMax』も提供しています。

次のフェーズでは、OrionStarはMoEを基にした生成式AIの持続開発とトレーニングを行います。

お楽しみに。

*モデルシリーズは以下となります、ご参考ください。

Orion-14B-Base: 2.5兆トークンの多様なデータセットでトレーニングされ、140億のパラメータを持つ多言語基本モデルです。

Orion-14B-Chat: 高品質なコーパスでファインチューニングされた対話型モデルで、大規模モデルコミュニティにより良いユーザーインタラクション体験を提供することを目指しています。

Orion-14B-LongChat: 20万トークンの長さで優れた効果を発揮し、最大で320,000トークンまでサポート可能で、長文書の評価セットでの性能は専用モデルに匹敵します。

Orion-14B-Chat-RAG: スタムの検索強化生成データセットでファインチューニングされたチャットモデルで、検索強化生成タスクで卓越した性能を発揮しています。

Orion-14B-Chat-Plugin: プラグインと関数呼び出しタスクに特化したチャットモデルで、代理を使用する関連するシナリオに適しています。大規模言語モデルがプラグインと関数呼び出しシステムの役割を果たします。

Orion-14B-Base-Int4: int4を使用して量子化された基本モデル。モデルサイズが70%縮小し、推論速度が30%向上し、わずか1%未満の性能低下しか発生しません。

Orion-14B-Chat-Int4: int4を使用して量子化された対話モデル。